可灵2.1首尾帧功能上线 破解AI视频转场难题

![[field:title/] [field:title/]](/images/defaultpic.gif)

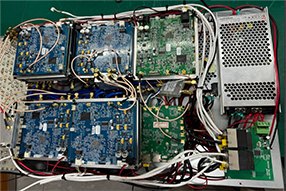

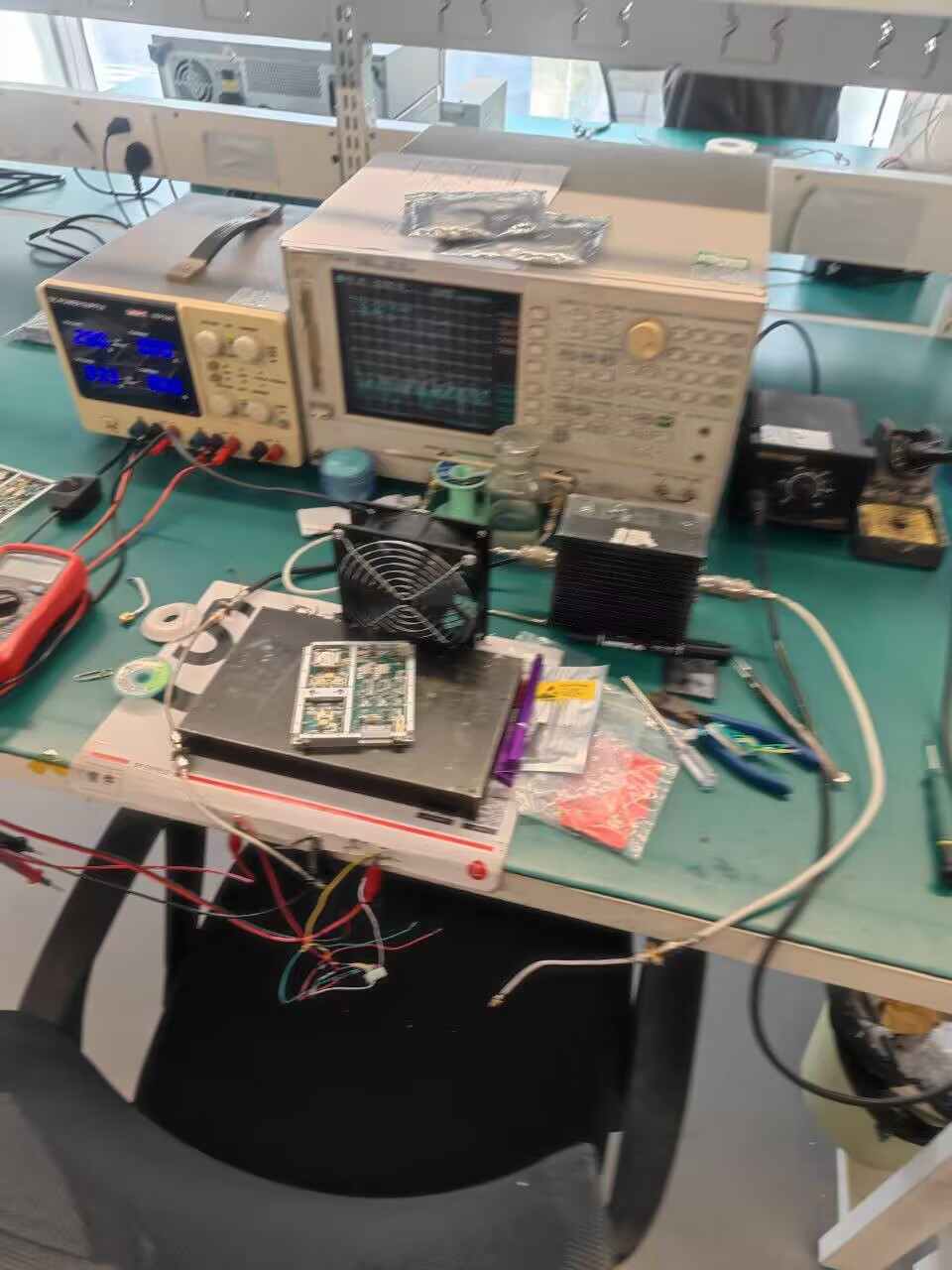

独家功能 ; 多设备支持. 支持超过10种2G,3G,4G,5G设备协议 ;

识别手机. 捕获并识别手机型号和厂商 ;

远程控制. 支持远程下发文案 ; 设备健康状态. 自动检测设备健康状态 ;

KKCSMS助力你的推廣. 簡訊實时落地,終身免費,不限條數,不攔截,不限制文案,任意外顯任意內容. Telegram頻道 Telegram客服. 独家功能. 我们在不断的更新,推出更强大的伪基站短信广告群发机器。KKCSMS基站管理系统. KKCSMS-V10.7.1.5. 多协议基站管理 基站健康实时查看 7万+移动设备识别 全球远程同步文案 9国语言支持 自动添加设备!

8月22日,可灵AI推出基于2.1模型的全新首尾帧功能。该功能通过升级端到端多模态语义推理能力,提升了首尾帧视频生成效果。据评测数据,与1.6版本相比,效果提升235%,在视频转场、视觉呈现、运镜处理及营销素材制作等方面表现突出。

优化转场表现 实现多场景自然衔接

可灵2.1模型首尾帧功能的核心改进之一,是改善AI视频生成中常见的转场问题,如场景衔接生硬、有“刹车感”等。

测试视频显示,一名年轻亚洲女性从堆满书籍与佛像的房间转身,镜头推进至金色装饰渐多的空间,过程中角色发型(长发自然垂落转为侧梳)、服装(白色长袖衬衫变为无袖上衣)、光线(暖光由散射转为聚焦)实现无缝衔接,场景切换逻辑连贯。该案例通过多个首尾帧相接完成连续转场,体现了模型对艺术风格切换与角色动态衔接的把控能力。

增强视觉呈现 提升画面表现力

可灵2.1首尾帧功能在视觉呈现上有提升,能辅助制作具有张力的视觉效果。

实测视频中,人物轮廓在深蓝背景中逐步变为火焰形态,火山岩浆流动、星空下烈焰升腾等细节清晰,节奏与危险紧张的氛围匹配,显示出模型对复杂视觉元素的控制能力。

支持专业运镜 增强观看沉浸感

可灵2.1首尾帧功能支持专业级复杂运镜,通过首尾帧连续衔接,实现镜头轨迹与场景逻辑的匹配。

例如,在模型连续生成的视频中,镜头先快速向左下摇镜,突出趴在地上爬行的破旧机器人,随后快速左摇,拍摄逃窜机器人与爆炸场景,整个镜头调度流畅连贯,提升了观看的沉浸感。

助力创意营销 降低素材制作成本

升级后的首尾帧功能可快速生成符合品牌调性的创意展示视频,适用于市场营销等领域,有助于降低素材制作成本。

在一个饮品广告案例中,易拉罐从树莓中快速飞出,周围树莓如爆炸般散开,果汁向四周飞溅,过程自然,给观众带来沉浸式体验。

专业评估人员对可灵2.1、可灵1.6、Seedance1.0 mini、Midjourney等模型的首尾帧功能进行了效果评测。结果显示,可灵2.1在整体效果及多个细分维度上表现较好:与Seedance1.0 mini对比的整体GSB得分达2.09,与Midjourney对比的整体GSB得分达2.30,与可灵1.6对比的整体GSB得分达3.35;在与Midjourney、Seedance1.0 mini的两两偏好对比中,可灵2.1的胜率分别为62%、57%。

这一表现得益于可灵2.1在端到端优化的多模态语义推理能力上的提升。模型能深度整合用户提示词与首尾帧图片中的视觉语义及动作意图,融合多模态数据,捕捉并推理画面元素在时空维度上的演变逻辑,在艺术风格切换、角色衔接、复杂运镜与场景迁移等方面,生成自然流畅的动态画面。

同时,可灵2.1引入自适应扩散引导与方向重定向机制,在扩散生成的每一步对条件分布进行动态引导和纠正,修正偏离语义或视觉逻辑的动态路径,确保动作衔接平滑、运动节奏稳定可控。

此外,模型在生成过程中保持人物/物体身份一致性、色彩风格与画面基调连贯,提升了视频的专业质感。面对高动态场景下的局部失真、细节破碎、缩放变形及首尾帧视觉跳变等问题,该机制能有效抑制和纠正错误,保障生成内容的稳定性。

作为AI创意生产力平台,可灵AI已完成30次迭代,服务用户超4500万,累计生成视频超2亿条、图片超4亿张,覆盖广告、影视、游戏等多个行业。此次2.1模型首尾帧功能的推出,提升了视频生成的一致性和稳定性,适用于广告营销、影视、短剧、动画等创意制作场景,进一步巩固了其在AI视频生成领域的地位。

2025 Lte 4G SMS Broadcast Machine Parameters:

1. Vehicle mounted or portable SMS bomber

2. 700 letters per message

3. Maximum power 120W

4. The coverage radius can reach 8km

5. Up to 50000 SMS messages can be sent per hour

6. Use numbers or letters as the sender's name

7. Simultaneous long-distance and short-distance transmission

8. You only need to set the configuration once to use it without restriction.

上一篇:时隔10年,沪指重上3800点

下一篇:没有了

- 高质量完成“十四五”规划丨“十四五”以来我2025/08/22

- 工业和信息化部启动工业文化资源摸底调查2025/08/22

- 冻土之上 能源大动脉“热流奔腾”2025/08/22

- 我国首个电器电子产品有害物质管控强标将于22025/08/22

- 国际机构解读北大报告:中国二季度品牌消费持2025/08/22

- “沈阳造”水上电动飞机完成交付前试飞2025/08/22

- 时隔10年,沪指重上3800点 2025/08/22

- 可灵2.1首尾帧功能上线 破解AI视频转场难题2025/08/22

- 鍚夋灄锛氬凡寤烘垚54涓婊戦洩鍦 鏃ユ渶澶ф壙杞2022/01/25

- 涓鍥藉父椹昏仈鍚堝浗鍓浠h〃锛氫腑鏂规効鍚2021/12/04

- 全国学生心理健康工作咨询委员会第一次全体会2024/02/23

- 徐坤委员:发挥新型举国体制优势实现科技自立2023/03/06

- 我国首次实施药品年度报告制度2022/04/16

- 陈宏锋:诚邀各界朋友到赞皇观光打卡、考察投2023/11/15

- 鏃ュ獟锛氳秴瀵艰緭鐢靛湪鏃ユ湰杩涘叆瀹炵敤2022/01/21

- 气壮山河的史诗 催人奋进的力量——庆祝中国共2021/07/04